文章目录

- 1. Introduction

- 2. SLAM Framework Based on Graph Optimization

- 3. The SLAM Framework of Low-Cost LiDAR and Vision Fusion

- 4. 2.5D Map Representation and Relocation

- 5. 实验结果

- 5.1 实验平台和环境

- 5.2 建图

- 5.3 重定位

1. Introduction

介绍了两种主流的SLAM方法:LiDAR和Visual,并介绍了其发展过程,然后提到了一些融合LiDAR和Visual的研究,当前硬件的价格和性能的矛盾,最后提出了本文的两点主要贡献:

- 提出了低成本激光视觉SLAM系统

- 对比特征地图,提出了能够快速重定位和回环检测的2.5D地图,该地图可以直接用于路径规划。

2. SLAM Framework Based on Graph Optimization

分别说明了使用视觉和LiADR各自相邻两帧之间的重投影误差构建的代价函数:

3. The SLAM Framework of Low-Cost LiDAR and Vision Fusion

论文的SLAM框架:

前端部分:

首先引入了相邻位姿下的Visual和LiDAR的联合误差函数,然后将其扩展到机器人的所有位姿,使用带有搜索域的LM算法对其进行求解。

后端部分:

使用词袋模型(BoW)进行回环检测,说明了其关键帧的选取规则。

4. 2.5D Map Representation and Relocation

首先说明了传统的栅格地图和特征地图的不足,然后提出了一种2.5D地图,即将竖直于同一栅格的特征地图信息存放在该栅格中,使栅格拥有了更多的环境信息。

最后提出了重定位算法:

- 用BoW提取当前帧的特征

- 将当前帧与先前的关键帧(带有位姿信息)匹配,选出匹配度最佳的n个关键帧

- 将这些关键帧的位姿作为粒子滤波器的初始估计值

- 应用粒子滤波算法至收敛

5. 实验结果

5.1 实验平台和环境

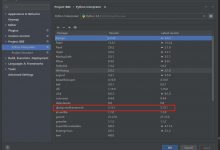

笔记本:Intel Core i5 处理器 and 8G内存,Ubuntu 14.04 + ROS Indigo系统

LiDAR:RPLIDAR-A2

RGB-D相机: Xtion-pro,深度测量范围为0.6-0.8m,精度为3mm,深度相机视角:水平58度,垂直45.5度。

5.2 建图

5.3 重定位

6. 总结

未来工作可以从两方面考虑:

- 开发或改进视觉激光数据关联算法使得SLAM在复杂、动态环境下表现出更好的性能。

- 将2.5D地图与场景、物体的语义信息相结合。

爱站程序员基地

爱站程序员基地