第八章 循环神经网络

循环神经网络的主要用途是处理和预测序列数据。它会记忆之前的信息,并利用之前的信息影响后面节点的输出。也就是说,循环神经网络的隐藏层之间的节点是有连接的,隐藏层的输入不仅包括输入层的输出还包括上一时刻隐藏层的输出。

droplet可以使神经网络更加健壮,不同层循环体之间会使用droplet。

下面为8.4的程序详解

# -*coding: utf-8 -*-import numpy as npimport tensorflow as tf# import matplotlib as mplfrom matplotlib import pyplot as pltHIDDEN_SIZE = 30 # LSTM中隐藏节点的个数。NUM_LAYERS = 2 # LSTM的层数。TIMESTEPS = 10 # 循环神经网络的训练序列长度。TRAINING_STEPS = 10000 # 训练轮数。BATCH_SIZE = 32 # batch大小。TRAINING_EXAMPLES = 10000 # 训练数据个数。TESTING_EXAMPLES = 1000 # 测试数据个数。SAMPLE_GAP = 0.01 # 采样间隔。def generate_data(seq):X = []y = []# 序列的第i项和后面的TIMESTEPS-1项合在一起作为输入;第i + TIMESTEPS项作为输# 出。即用sin函数前面的TIMESTEPS个点的信息,预测第i + TIMESTEPS个点的函数值。for i in range(len(seq) - TIMESTEPS):X.append([seq[i: i + TIMESTEPS]])y.append([seq[i + TIMESTEPS]])return np.array(X, dtype=np.float32), np.array(y, dtype=np.float32)def lstm_model(X, y, is_training):# 使用多层的LSTM结构。cell = tf.nn.rnn_cell.MultiRNNCell([tf.nn.rnn_cell.BasicLSTMCell(HIDDEN_SIZE) for _ in range(NUM_LAYERS)])# 使用TensorFlow接口将多层的LSTM结构连接成RNN网络并计算其前向传播结果。outputs, _ = tf.nn.dynamic_rnn(cell, X, dtype=tf.float32)#outputs是顶层LSTM在每一步的输出结果,它的维度是[batch_size, time, HIDDEN_SIZE]。# 在本问题中只关注最后一个时刻的输出结果output = outputs[:, -1, :]# 对LSTM网络的输出再做加一层全链接层并计算损失。注意这里默认的损失为平均# 平方差损失函数。predictions = tf.contrib.layers.fully_connected(output, 1, activation_fn=None)# 只在训练时计算损失函数和优化步骤。测试时直接返回预测结果。if not is_training:return predictions, None, None# 计算损失函数。loss = tf.losses.mean_squared_error(labels=y, predictions=predictions)# 创建模型优化器并得到优化步骤。train_op = tf.contrib.layers.optimize_loss(loss, tf.train.get_global_step(), optimizer=\'Adagrad\', learning_rate=0.1)return predictions, loss, train_opdef train(sess, train_X, train_y):# 将训练数据以数据集的方式提供给计算图。ds = tf.data.Dataset.from_tensor_slices((train_X, train_y))ds = ds.repeat().shuffle(1000).batch(BATCH_SIZE)X, y = ds.make_one_shot_iterator().get_next()# 调用模型,得到预测结果、损失函数,和训练操作。with tf.variable_scope(\"model\"):predictions, loss, train_op = lstm_model(X, y, True)# 初始化变量sess.run(tf.global_variables_initializer())for i in range(TRAINING_STEPS):_, l = sess.run([train_op, loss])if i % 100 == 0:print(\"train step:\" + str(i) + \", loss:\" + str(l))def run_eval(sess, test_X, test_y):# 将测试数据以数据集的方式提供给计算图ds = tf.data.Dataset.from_tensor_slices((test_X, test_y))ds = ds.batch(1)X, y = ds.make_one_shot_iterator().get_next()# 调用模型得到计算结果。这里不需要输入真实的y值。with tf.variable_scope(\"model\", reuse=True):prediction, _, _ = lstm_model(X, [0.0], False)# 将预测结果存入一个数组。predictions = []labels = []for i in range(TESTING_EXAMPLES):p, l = sess.run([prediction, y])predictions.append(p)labels.append(l)# 计算rmse作为评价指标。predictions = np.array(predictions).squeeze()labels = np.array(labels).squeeze()rmse = np.sqrt(((predictions -labels) ** 2).mean(axis=0))print(\"Mean Square Error is : %f\" % rmse)# 对预测的sin函数曲线进行绘图。plt.figure()plt.plot(predictions, label=\'predictions\')plt.plot(labels, label=\'real_sin\')plt.legend()plt.show()if __name__ == \'__main__\':# 用正弦函数生成训练和测试数据集合。# numpy.linspace函数可以创建一个等差序列的数组,常用的参数有三个,第一个表示起始值,第二个表示终止值# 第三个表示序列的长度。例如 linespace(1, 10, 10)# 产生的数组 array([1,2,3,4,5,6,7,8,9,10])test_start = (TRAINING_EXAMPLES + TIMESTEPS) * SAMPLE_GAPtest_end = test_start + (TESTING_EXAMPLES + TIMESTEPS) * SAMPLE_GAPtrain_X, train_y = generate_data(np.sin(np.linspace(0, test_start,TRAINING_EXAMPLES + TIMESTEPS, dtype=np.float32)))test_X, test_y = generate_data(np.sin(np.linspace(test_start, test_end, TESTING_EXAMPLES + TIMESTEPS, dtype=np.float32)))with tf.Session() as sess:# 训练模型。train(sess, train_X, train_y)# 使用训练好的模型对测试数据进行预测。run_eval(sess, test_X, test_y)

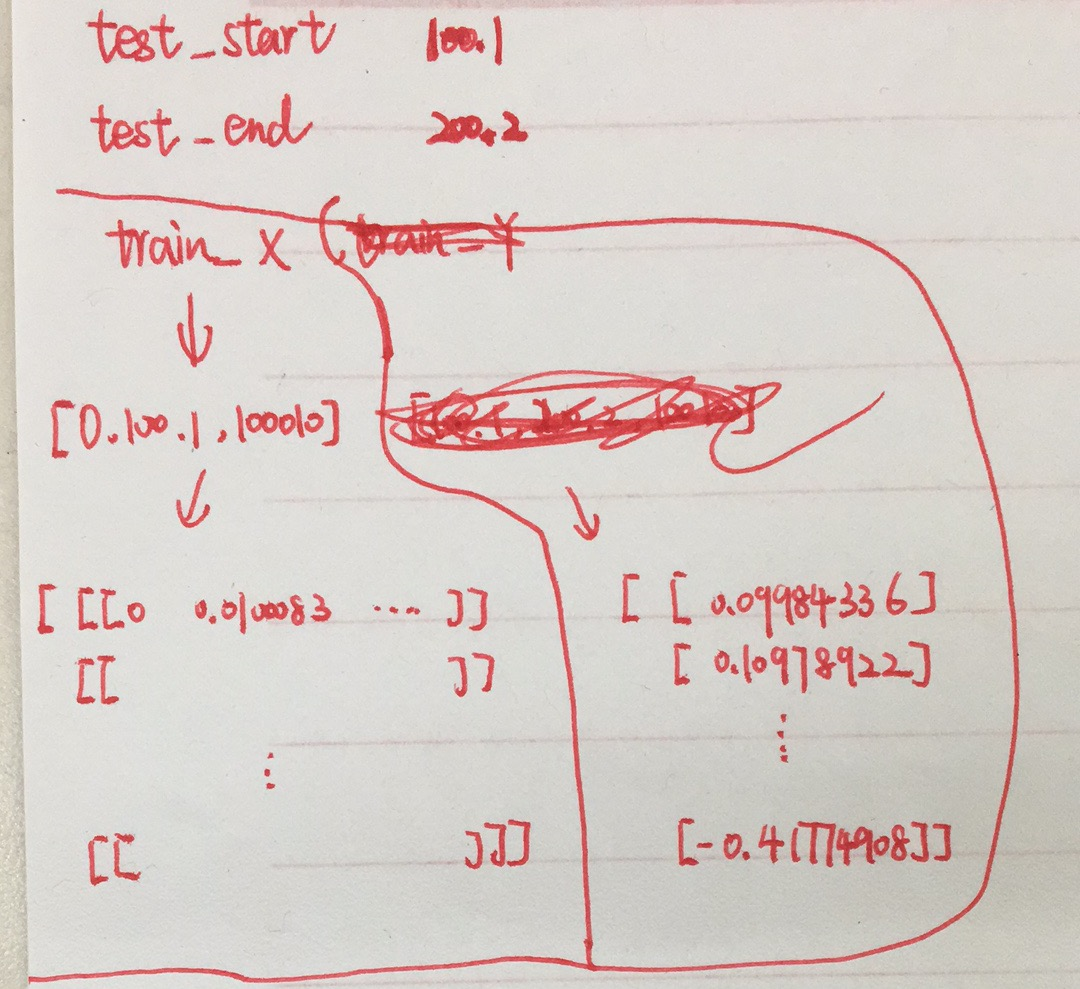

数据的输入格式为

转载于:https://www.cnblogs.com/beautifulchenxi/p/11322048.html

爱站程序员基地

爱站程序员基地